Por Leonardo Carvajalino

Periodista

carvajalino.leonardo@gmail.com

Investigación asociada al grupo Biomedical Signal Processing and Artificial Intelligence (BSPAI).

El avance en la inteligencia artificial ha permitido diseñar sistemas capaces de llegar a respuestas que a especialistas les toma décadas. No obstante, quienes las crean no están del todo seguros de cómo es que están llegando a dichas conclusiones.

¿Creerías en el diagnóstico médico de una máquina que acierta con la misma efectividad que un especialista, pero que no es capaz de explicar cómo llegó a esa conclusión? Esta pregunta parece el planteamiento de una película de ciencia ficción, no obstante, la humanidad tiene que empezar a hacérsela. Los desarrollos en la inteligencia artificial la han acercado poco a poco a nuestro diario vivir y el futuro apunta a un mundo en el que las máquinas dominarán muchas áreas del conocimiento.

Y aun cuando los imaginarios hollywoodenses dictan que con la evolución de estas máquinas inteligentes llegará el fin de la raza humana, la realidad, mucho menos terrorífica, conserva algunos misterios. Lejos de crear robots humanoides dotados de razonamiento, actualmente los investigadores son capaces de programar inteligencia artificial que hace ciertas tareas mejor que los humanos. El problema es que no saben exactamente cómo es que la máquina aplica el conocimiento adquirido para llegar a conclusiones correctas.

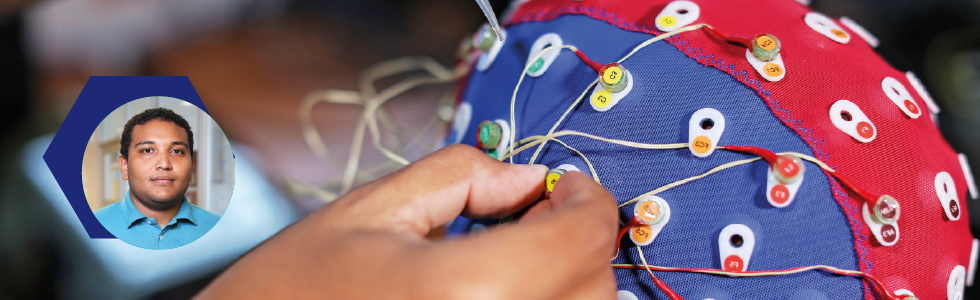

“Ya no entendemos nuestras propias máquinas. Si hay alguien que dice que entiende perfectamente cómo funcionan, está mintiendo. Sabemos la matemática que hay dentro, es muy sencilla, pero cuando juntamos todo, no tenemos ni idea de qué es lo que está sucediendo”, dice Winston Percybrooks. El docente e investigador es uno de los coordinadores del Biomedical Signal Processing and Artificial Intelligence (BSPAI) Lab de la Universidad del Norte; desde allí trabaja con estudiantes de maestría y doctorado en proyectos relacionados con la aplicación de inteligencia artificial y procesamiento de señales, con un enfoque último en mente: ser capaces de acercarse cada vez más a respuestas de cómo es que una máquina aplica lo aprendido.

▲ Percybrooks junto a Christian Olivares, Mauro Jiménez, Catherine Díaz y Pedro Narváez, estudiantes de maestría y doctorado que trabajan sus proyectos en el Biomedical Signal Processing and Artificial Intelligence (BSPAI) Lab.

“ES POSIBLE QUE NUNCA SEPAMOS CÓMO UN SISTEMA LLEGA A LAS RESPUESTAS, Y TENGAMOS QUE LLAMARLE SENTIDO COMÚN ARTIFICIAL”.

Percybrooks afirma que programar inteligencia artificial es relativamente sencillo, y que solo con práctica y el dominio de álgebra lineal —matemáticas que normalmente ven los estudiantes en los primeros semestres de ingeniería— se puede llegar a resultados “sorprendentes”. Mediante el proceso conocido como machine learning es posible que una máquina pueda analizar datos y discernir entre ellos para hallar respuestas que requieren años de estudio y experiencia para un ser humano. No obstante, nadie es capaz de explicar exactamente cómo es que la máquina está aprendiendo y llegando a estos resultados.

Esta falta de respuestas es heredada de vacíos que aún existen en la ciencia en general. No conocemos neurológicamente cómo es el proceso, paso a paso, que ocurre en el cerebro humano que lo lleva a aprender. Hay indicios y teorías; sabemos que utilizando la experiencia, el ser humano puede replicar comportamientos hasta perfeccionar la exactitud de la actividad que realiza.

Como en la metáfora utilizada arriba, un especialista médico para ser capaz de diagnosticar con precisión debe haber estudiado una carrera en la que adquirió la teoría, y luego haber atendido miles de pacientes. Los programadores replican, con gran éxito, este proceso para que una máquina aprenda desde la experiencia adquirida en un tiempo muchísimo menor. Al final ambos comparten una misma problemática.

Imaginemos que una persona llega al consultorio de un profesional de la salud. Este le diagnostica una enfermedad. Como es natural, el paciente le hará preguntas para entender. El especialista le explicará cómo llegó a esa conclusión, sin embargo, habrá una parte de ese conocimiento, de cómo sabe lo que sabe, que será imposible de comunicar, lo que llamamos intuición o sentido común. “Si nosotros mismos no podemos explicar completamente cómo llegamos a nuestras conclusiones, ¿cómo lo haremos con las máquinas? Vamos a tener que aprender a convivir con sistemas que den explicaciones incompletas”, puntualiza Percybrooks.

Ante esta situación, se han comenzado a crear regulaciones a nivel mundial como lo hizo la Unión Europea en diciembre de 2018. Uno de los requisitos incluidos dentro de las directrices es que los operadores sean capaces de explicar las decisiones que tomen sus sistemas de IA.

Percybrooks argumenta que “es posible que nunca sepamos cómo llega a las respuestas y tengamos que llamarle sentido común artificial”. Existen muchas iniciativas a nivel mundial con importantes recursos detrás, como BRAIN Initiative, Blue Brain Project y Human Brain Project, que desde hace muchos años intentan conocer más sobre el funcionamiento del cerebro humano. No obstante, las preguntas continúan mientras mejora cada vez más la precisión de la inteligencia artificial.

“Por el lado de algoritmos de inteligencia artificial, tenemos que entender mejor internamente cómo están llegando a las conclusiones que llegan y tenemos que desarrollar mecanismos para que eventualmente el modelo de inteligencia artificial mismo sea capaz de comprender cómo está llegando a esas conclusiones y expresarlo en su respuesta”, dice el PhD en Electrical and Computer Engineering del Georgia Institute of Technology.

Con este panorama en mente, el equipo integrado por tres profesores y siete estudiantes de maestría y doctorado se reúne todos los días para trabajar en sus proyectos. El laboratorio es un espacio decorado por un escritorio en cada pared y computadores abiertos mostrando sus entrañas de cable, plástico y metal. A veces, el lugar parece un centro de investigaciones pedagógicas, pues los verbos enseñar y aprender son los más usados. Y para entender lo que hacen allí, se debe entender lo que es una red neuronal artificial.

▲ Pedro Narváez se encuentra desarrollando un estetoscopio capaz de identificar arritmias cardíacas a través de un software que utiliza inteligencia artificial para detectar las irregularidades en el sonido del corazón

Cómo aprenden las máquinas

Ejemplos. Miles y miles de ellos. Solo con datos es posible programar una red neuronal artificial, es decir, un modelo computacional capaz de recibir información, analizarla y dar una respuesta. Por ejemplo, uno de los proyectos que se encuentran trabajando en el laboratorio BSPAI es un fonendoscopio capaz de distinguir entre ritmos cardíacos normales y anormales. El proyecto fue pensado y diseñado por el profesor Percybrooks y Pedro Narváez, estudiante de doctorado en Ingeniería Electrónica.

Utilizando ejemplos tomados de pacientes del Hospital Universidad del Norte, han desarrollado un prototipo que en dos ocasiones ha ganado apoyo financiero de Google. La herramienta médica está pensada para funcionar a través de una aplicación de celular que escuche el ritmo cardíaco, lo grabe y lo suba a un servidor que, por medio de un algoritmo, busca irregularidades y arroja un resultado.

Los investigadores utilizaron la técnica de aprendizaje supervisado. Es decir, ingresaron una base de datos con ritmos normales y anormales y los clasificaron para la máquina de acuerdo con ciertas características que buscaban, en este caso sonidos donde debería haber silencios entre la sístole y la diástole. Narváez cuenta que el estetoscopio está pensado como una herramienta de telemedicina; para que funcione manejado por personal médico en sitios donde no haya cardiólogos.

Por esta razón, quisieron llevarlo más allá y entrenar al software para que sea capaz de identificar qué tipo de anormalidad presenta el paciente. “Nos encontramos con una barrera, la falta de muestras”, señala el estudiante de tercer año de doctorado. Para que una máquina sea precisa necesita de muchos más ejemplos que un ser humano. Pero, por la naturaleza de estas enfermedades, es muy difícil conseguir una gran cantidad de muestras de pacientes.

Narváez se puso a la tarea de crear una inteligencia artificial capaz de generar sonidos sintéticos de dolencias cardíacas. Para esto, diseñó dos redes neuronales, una genera ritmos cardíacos mientras que la otra identifica y diferencia los sonidos reales de los sintéticos. La primera busca engañar a la segunda mediante un paradigma que se conoce como Redes Generativas Adversarias (GANs en inglés). Es decir, la red neuronal intenta repetir aquello que le resultó exitoso mientras que se abstiene de aquellos sonidos que son reconocidos como falsos.

▲ Catherine Diaz, Se encuentra desarrollado el robot autónomo llamado "Call me Waiter"

Por su parte Catherine Díaz, otra de las integrantes del laboratorio, utiliza la técnica de aprendizaje por refuerzo para programar el robot Call Me Waiter. “En este campo, usualmente los que se han implementado han fracasado porque los robots eran seguidores de línea, nada más podían ir por un camino definido y no eran escalables, no podían aprender más cosas”, explica la joven. Su idea consiste en una especie de R2D2, el emblemático robot de la saga de Star Wars, que sirva tanto para la casa como para un restaurante. La clave: que su invento aprenda a moverse efectivamente en un espacio.

Se trata de aprendizaje por refuerzo, porque el robot, hasta el momento una base plana con ruedas, es capaz de moverse en el entorno libremente. Por cada movimiento recibe un puntaje positivo o negativo. La máquina está buscando, como si fuera un juego, obtener la mayor cantidad de puntos posibles. Aquello que baja su puntaje tiende a no repetir, y de esta forma, como si fuera un animal, se refuerzan las conductas positivas hasta que se optimice su comportamiento.

El diseño de Díaz tiene como objetivo optimizar las rutas que toma desde la cocina hasta la mesa. Para esto contará con una base con sensores de impacto, y una cámara que pueda identificar cuando es llamado mediante la lectura de un código QR. Una vez sea llamado, el robot debe ser capaz de seguir la ruta más corta posible, habilidad que adquiere con la práctica y la constante puntuación que se da a sí mismo de acuerdo con la escala de valores que se programa como conductas buenas o malas. Actualmente, la estudiante se encuentra trabajando en un prototipo.

▲ Mauro Jiménez tiene como objetivo que el software en el que trabaja sea una herramienta para identificar si se está cometiendo plagio en la música.

Otro paradigma que se utiliza en el aprendizaje de máquinas es el de tipo no supervisado, técnica que utiliza Mauro Jiménez, otro de los estudiantes de maestría que desarrollan proyectos en el laboratorio. El joven se encuentra trabajando en un modelo computacional que identifique géneros musicales. Para entrenar al programa, se le introduce una base de datos, una biblioteca de muestras de audio ya preclasificada por un experto musical.

La máquina no tiene oídos y por ende su forma de aprendizaje no es la escucha. Jiménez convierte estas muestras de audio a un set de variables de interés, como notas, subidas y bajadas en el tono, o cambio en la voz, a un lenguaje que la máquina entienda: algoritmos, vectores, funciones y matrices.

El aprendizaje no supervisado consiste en que, luego de analizar una cantidad importante de ejemplos, la máquina comienza a darle valor a las características que determinan lo que está clasificando y, crea jerarquías propias entre estos rasgos. De esta forma, la máquina crea un set de particularidades para discernir entre los ejemplos que le fueron dados.

“La idea es tratar de crear una métrica objetiva para clasificar los estilos o géneros que hay a nivel musical”, explica Jiménez. La meta: que el modelo computacional, a través de la métrica objetiva, pueda conocer si se está cometiendo plagio.

▲ El primer experimento que Christian Olivares realizó con interfaces cerebro computadoras (BCI) fue una silla de ruedas que se mueve de acuerdo con el color que mire el usuario en una pantalla.

español

español inglés

inglés francés

francés alemán

alemán